DeepSeek-R1登顶Nature封面:中国AI团队用200万创造科学奇迹

预计阅读时间: 8分钟 (基于平均阅读速度250字/分钟,包含概念理解时间)

Nature封面上的中国AI少年:DeepSeek-R1如何用200万撬动全球科技圈?

目录

- 核心科学概念

- 引言:一场科学逆袭的开端

- 低成本科学冒险:重新定义AI研发经济学

- 强化学习:AI如何像人类一样学习

- 科学影响与社会意义

- 科学问答:澄清常见误解

核心科学概念

- 强化学习(RLHF): 通过奖励和惩罚机制训练AI系统的方法

- 数学推理: AI理解和解决数学问题的能力

- 模型训练成本: 开发AI系统所需的经济和计算资源

- 科学民主化: 使先进技术工具对更广泛群体可及的过程

引言:一场科学逆袭的开端

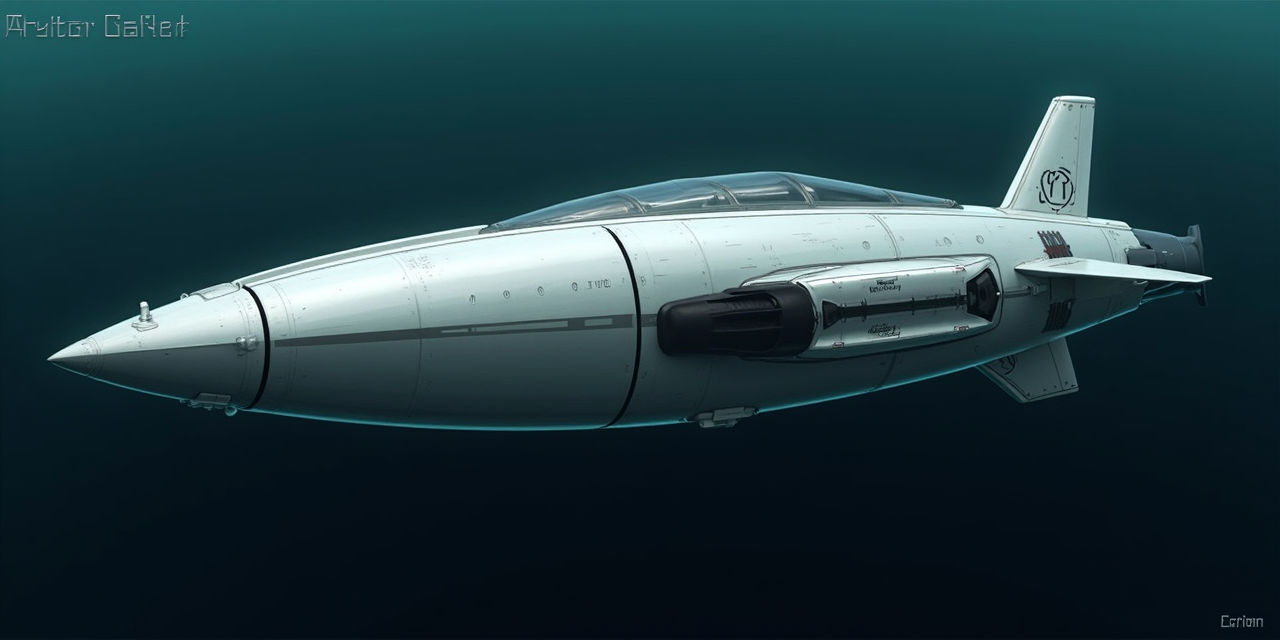

2025年2月14日,北京中关村的一间实验室里,梁文锋团队按下了论文投稿按钮。5个月后,他们收到《Nature》编辑部的修改意见;9月17日,这篇题为《Scaling Reinforcement Learning from Human Feedback for Mathematical Reasoning》的论文,带着深蓝色的DeepSeek-R1模型示意图,出现在全球最权威科学期刊的封面上。

“这不仅是技术的胜利,更是一场属于中国Z世代的科学逆袭。”

低成本科学冒险:重新定义AI研发经济学

DeepSeek-R1的训练成本仅29.4万美元(约208万人民币)——相当于一线城市一套房的首付,或是某国际AI团队单日电费开支。这一成本比传统AI模型开发低了两个数量级:

- 训练耗电仅18.6万度,相当于3000部手机充电一年

- 成本仅为同类大模型的0.1%-1%

- 若用同等电力训练GPT-4,仅能运行4小时

这种”极致性价比”模式证明了科学突破未必需要天价投入,为资源有限的研究团队开辟了新可能性。

强化学习:AI如何像人类一样学习

团队通过强化学习(RLHF)技术,让模型像学生刷题一样学习:解对数学题获得”奖励”,错误时接受”惩罚”。这种受行为心理学启发的训练方法,使模型在MATH数据集(涵盖高中数学至竞赛题)上准确率超过90%。

“可以将RLHF理解为’AI驯兽师’——通过奖励期望行为、惩罚不期望行为,逐步塑造模型的推理能力。”

与需要海量标注数据的监督学习不同,强化学习只需要相对较少的人类反馈就能引导AI系统自我改进,这大大降低了数据准备成本。

方法论突破:纯强化学习路径

此前AI界盛行”蒸馏法”:通过模仿OpenAI等巨头模型的输出训练小模型,如同仿酿茅台。但梁文锋团队坚持原创路径,论文附录公开全部训练日志,证实”未使用任何蒸馏数据”。

这种透明性正是《Nature》审稿人最赞赏的部分。研究团队提供了:

- 完整的训练日志和超参数设置

- 模型决策过程的详细分析

- 与传统方法的对比实验结果

这种方法论上的严谨性,为AI研究的可重复性设立了新标准。

科学影响与社会意义

DeepSeek-R1的成功超越了技术层面,预示着科学民主化的未来。这种低成本模式让偏远地区学校未来也能训练专属AI导师,可能彻底改变教育资源分配格局。

正如梁文锋在论文致谢中所写:”献给所有相信小团队也能改变世界的年轻人。”这项研究证明了创新不一定需要巨额资金,而更需要创造性思维和科学严谨性。

科学问答:澄清常见误解

问:低成本AI模型是否意味着性能妥协?

答:不一定。DeepSeek-R1在MATH数据集上准确率超过90%,媲美GPT-4。低成本主要来自算法效率提升,而非性能妥协。这项研究证明通过算法创新可以大幅提升计算效率。

问:强化学习与传统机器学习方法有何根本区别?

答:强化学习不需要大量预先标注的数据,而是通过试错和奖励机制学习。这更像人类学习方式——通过行动后果来调整行为,而不是通过记忆范例。

问:这项研究对STEM教育有何实际意义?

答:它降低了AI研发门槛,使中小学校和资源有限的机构也能开发专用AI工具。未来,学校可能训练针对本地学生需求的AI辅导员,实现个性化教育。

问:AI模型的”透明度”为何在科学研究中重要?

答:透明度确保研究可重复、可验证——这是科学方法的基石。DeepSeek-R1公开训练日志和 methodology,允许其他科学家检验和构建 upon 他们的工作,加速科学进步。

参考文献及数据来源: Nature论文原文, DeepSeek技术报告, MATH数据集论文. 成本换算按2025年9月汇率(1美元≈7.08人民币).